Data Warehouse: Unterschied zwischen den Versionen

Die Seite wurde neu angelegt: „Leistungsfähige Business-Intelligence-Systeme basieren auf dem Data-Warehouse-Konzept. Dabei werden Daten aus verschiedenen internen…“ |

Keine Bearbeitungszusammenfassung |

||

| (2 dazwischenliegende Versionen desselben Benutzers werden nicht angezeigt) | |||

| Zeile 1: | Zeile 1: | ||

Leistungsfähige [[Business Intelligence|Business-Intelligence-Systeme]] basieren auf dem Data-Warehouse-Konzept. Dabei werden Daten aus verschiedenen internen und externen Quellsystemen erschlossen und in einem Daten-Pool (Data Warehouse) gesammelt (Müller & Lenz, 2013, S. 11). Mitarbeitende können diesen integrierten Datenbestand dann mittels speziellen Analyse-Funktionen (z.B. automatisierte Cockpits, Dashboards, OLAP-Abfragen, [[Data Mining|Data Mining]]) erschliessen (Schön & Liebe, 2014, S. 244). | Leistungsfähige [[Business Intelligence|Business-Intelligence-Systeme]] basieren auf dem Data-Warehouse-Konzept. Dabei werden Daten aus verschiedenen internen und externen Quellsystemen erschlossen und in einem Daten-Pool (Data Warehouse) gesammelt (Müller & Lenz, 2013, S. 11). Mitarbeitende können diesen integrierten Datenbestand dann mittels speziellen Analyse-Funktionen (z.B. automatisierte Cockpits, Dashboards, OLAP-Abfragen, [[Data Mining|Data Mining]]) erschliessen (Schön & Liebe, 2014, S. 244). | ||

== Data-Warehouse-Architektur == | == Data-Warehouse-Architektur == | ||

[[Datei:Architektur_eines_Data_Warehouses_(Müller_%26_Lenz,_2013,_S._19).png|miniatur| | [[Datei:Architektur_eines_Data_Warehouses_(Müller_%26_Lenz,_2013,_S._19).png|miniatur|450px|Abb. 1: Architektur eines Data Warehouses (Müller & Lenz, 2013, S. 19)]] | ||

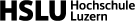

In Abbildung 1 ist die Data-Warehouse-Architektur schematisch dargestellt. In einem ersten Schritt werden Daten aus Quellsystemen erschlossen. Anschliessend werden sie mittels ETL-Prozessen (Extraktion, Transformation, Laden) in den Daten-Pool des Data | In Abbildung 1 ist die Data-Warehouse-Architektur schematisch dargestellt. In einem ersten Schritt werden Daten aus Quellsystemen erschlossen. Anschliessend werden sie mittels ETL-Prozessen (Extraktion, Transformation, Laden) in den Daten-Pool des Data Warehouse geladen und dort verwaltet. Im letzten Schritt können Nutzende mit verschiedenen Anwendungen auf die gewonnenen Daten zugreifen und diese für Analysezwecke nutzen. | ||

Die einzelnen Schritte werden in den folgenden drei Kapiteln genauer erläutert. | Die einzelnen Schritte werden in den folgenden drei Kapiteln genauer erläutert. | ||

== Datenquellen == | == Datenquellen == | ||

| Zeile 9: | Zeile 9: | ||

Das Data Warehouse dient somit bei Datenauswertungs-Fragen als Single Point of Truth (SPOT) (Ereth & Kemper, 2016, S. 460). Dies bietet den Vorteil, dass sämtliche Mitarbeitenden Auswertungen mit demselben integrierten Datenbestand im Data Warehouse ausführen. Die Auswertungsmöglichkeiten im Data Warehouse sind deutlich umfangreicher und flexibler als z. B. in einem ERP-System. Ausserdem beeinträchtigen komplexe Abfragen dank der Trennung von Data Warehouse und Quellsystemen die Performance der operativen Quellsysteme nicht (Schön, 2018, S. 316–318). | Das Data Warehouse dient somit bei Datenauswertungs-Fragen als Single Point of Truth (SPOT) (Ereth & Kemper, 2016, S. 460). Dies bietet den Vorteil, dass sämtliche Mitarbeitenden Auswertungen mit demselben integrierten Datenbestand im Data Warehouse ausführen. Die Auswertungsmöglichkeiten im Data Warehouse sind deutlich umfangreicher und flexibler als z. B. in einem ERP-System. Ausserdem beeinträchtigen komplexe Abfragen dank der Trennung von Data Warehouse und Quellsystemen die Performance der operativen Quellsysteme nicht (Schön, 2018, S. 316–318). | ||

== ETL-Prozess und Datenverwaltung == | == ETL-Prozess und Datenverwaltung == | ||

Die Daten aus den Quellsystemen werden mittels ETL-Prozessen ins Data Warehouse importiert. ETL steht dabei für Extraktion, Transformation, Laden. Bei der '''Extraktion''' werden die relevanten Daten in den Quellsystemen identifiziert und in einem Arbeitsbereich des Data | Die Daten aus den Quellsystemen werden mittels ETL-Prozessen ins Data Warehouse importiert. ETL steht dabei für Extraktion, Transformation, Laden. Bei der '''Extraktion''' werden die relevanten Daten in den Quellsystemen identifiziert und in einem Arbeitsbereich des Data Warehouse abgelegt. Danach werden die extrahierten Daten im Teilschritt '''Transformation''' zusammengeführt, harmonisiert, mit zusätzlichen Informationen angereichert und von syntaktischen Mängeln bereinigt, damit sie in die einheitliche Datenstruktur des Data Warehouse passen. Beim dritten Teilschritt, dem '''Laden''', werden die extrahierten und transformierten Daten in die Zieldatenbank des Data Warehouse transferiert (Schön, 2018, S. 348–350; Müller & Lenz, 2013, S. 26–27). | ||

Aus dem Kern-Data-Warehouse werden die Daten dann gezielt in kleinere Data Marts überführt. Die Data Marts erfüllen spezifische Aufgabenbereiche und genau für diese speziellen Einsatzgebiete werden die Daten sinnvoll aufbereitet (Schön, 2018, S. 342). | Aus dem Kern-Data-Warehouse werden die Daten dann gezielt in kleinere Data Marts überführt. Die Data Marts erfüllen spezifische Aufgabenbereiche und genau für diese speziellen Einsatzgebiete werden die Daten sinnvoll aufbereitet (Schön, 2018, S. 342). | ||

== Datenauswertung und -nutzung == | == Datenauswertung und -nutzung == | ||

[[Datei:OLAP_Roll-Up_und_Drill-Down_(Müller_%26_Lenz,_2013,_S._55).png|miniatur| | [[Datei:OLAP_Roll-Up_und_Drill-Down_(Müller_%26_Lenz,_2013,_S._55).png|miniatur|400px|Abb. 2: OLAP Roll-Up und Drill-Down (Müller & Lenz, 2013, S. 55)]] | ||

Liegen die Datenbestände im Kern-Data-Warehouse oder den Data Marts bereit, so kann das Unternehmen sie mit Hilfe unterschiedlicher Analyse-, Präsentations- und Planungstools auswerten und zur Informationsgewinnung nutzen. Es existieren zwei grundlegende Typen von | Liegen die Datenbestände im Kern-Data-Warehouse oder den Data Marts bereit, so kann das Unternehmen sie mit Hilfe unterschiedlicher Analyse-, Präsentations- und Planungstools auswerten und zur Informationsgewinnung nutzen. Es existieren zwei grundlegende Typen von Auswertungsanwendungen: Deskriptive/diagnostische Analyseanwendungen und explorative Analyseanwendungen (Schön, 2018, S. 345–346). | ||

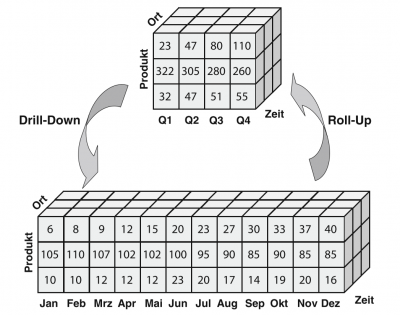

Die traditionellen Einsatzgebiete von [[Business Intelligence|Business Intelligence]] sind deskriptive (Was ist passiert?) und diagnostische (Warum ist etwas passiert?) Analyseanwendungen (Ereth & Kemper, 2016, S. 459). Darunter fallen z. B. SQL-basierte freie Datenrecherchen, die Analyse von Daten mittels OLAP-Berichtsgeneratoren (Online Analytical Processing) oder visuell gestaltete Dashboards die als Reporting-Tools für das Management dienen (Schön, 2018, S. 346). Abbildung 2 veranschaulicht ein Beispiel der in der BI wichtigen mehrdimensionalen OLAP-Datenwürfel. Mittels Drill-Down und Roll-Up Funktionalitäten können Mitarbeitende umfangreiche Datenbestände schnell und einfach mit verschiedenen Kriterien analysieren. Wenn Mitarbeitende der Fachabteilungen solche ad-hoc-Abfragen oder Dashboards im Data Warehouse unabhängig von der IT-Abteilung oder dem Controlling erstellen können, so spricht man von [[Self-Service Business Intelligence|Self-Service Business Intelligence]]. | Die traditionellen Einsatzgebiete von [[Business Intelligence|Business Intelligence]] sind deskriptive (Was ist passiert?) und diagnostische (Warum ist etwas passiert?) Analyseanwendungen (Ereth & Kemper, 2016, S. 459). Darunter fallen z. B. SQL-basierte freie Datenrecherchen, die Analyse von Daten mittels OLAP-Berichtsgeneratoren (Online Analytical Processing) oder visuell gestaltete Dashboards die als Reporting-Tools für das Management dienen (Schön, 2018, S. 346). Abbildung 2 veranschaulicht ein Beispiel der in der BI wichtigen mehrdimensionalen OLAP-Datenwürfel. Mittels Drill-Down und Roll-Up Funktionalitäten können Mitarbeitende umfangreiche Datenbestände schnell und einfach mit verschiedenen Kriterien analysieren. Wenn Mitarbeitende der Fachabteilungen solche ad-hoc-Abfragen oder Dashboards im Data Warehouse unabhängig von der IT-Abteilung oder dem Controlling erstellen können, so spricht man von [[Self-Service Business Intelligence|Self-Service Business Intelligence]]. | ||

Die zweite Gruppe von | Die zweite Gruppe von Auswertungsanwendungen bilden die explorativen Analyseanwendungen. Sie beantworten vor allem prädikative (Was wird passieren?; vgl. [[Predictive Forecasting| Predictive Forecasting]]) und präskriptive (Was ist zu tun?) Fragestellungen. Dazu gehört z. B. [[Data Mining|Data Mining]] bei welchem mittels ausgeklügelten mathematischen Modellen und Algorithmen in riesigen Datenmengen nach Mustern und Auffälligkeiten gesucht wird. Diese Anwendungen fallen eher in den Bereich von [[Business Analytics|Business Analytics]], welcher über den deskriptiven/diagnostischen Bereich von [[Business Intelligence|Business Intelligence]] hinausgeht (Ereth & Kemper, 2016, S. 459–460). | ||

== Quellen == | == Quellen == | ||

* Ereth, J. & Kemper, H.-G. (2016). [https://elearning.hslu.ch/ilias/goto.php?target=file_3939261_download&client_id=hslu Business Analytics und Business Intelligence.] Controlling, 28 (8–9), 458–464. | * Ereth, J. & Kemper, H.-G. (2016). [https://elearning.hslu.ch/ilias/goto.php?target=file_3939261_download&client_id=hslu Business Analytics und Business Intelligence.] Controlling, 28 (8–9), 458–464. | ||

Aktuelle Version vom 7. Dezember 2019, 17:19 Uhr

Leistungsfähige Business-Intelligence-Systeme basieren auf dem Data-Warehouse-Konzept. Dabei werden Daten aus verschiedenen internen und externen Quellsystemen erschlossen und in einem Daten-Pool (Data Warehouse) gesammelt (Müller & Lenz, 2013, S. 11). Mitarbeitende können diesen integrierten Datenbestand dann mittels speziellen Analyse-Funktionen (z.B. automatisierte Cockpits, Dashboards, OLAP-Abfragen, Data Mining) erschliessen (Schön & Liebe, 2014, S. 244).

Data-Warehouse-Architektur

In Abbildung 1 ist die Data-Warehouse-Architektur schematisch dargestellt. In einem ersten Schritt werden Daten aus Quellsystemen erschlossen. Anschliessend werden sie mittels ETL-Prozessen (Extraktion, Transformation, Laden) in den Daten-Pool des Data Warehouse geladen und dort verwaltet. Im letzten Schritt können Nutzende mit verschiedenen Anwendungen auf die gewonnenen Daten zugreifen und diese für Analysezwecke nutzen. Die einzelnen Schritte werden in den folgenden drei Kapiteln genauer erläutert.

Datenquellen

Voraussetzung für ein Data Warehouse bilden verschiedene interne und externe Quellsysteme, aus welchen die zu analysierenden Daten stammen. Interne Systeme können hierbei z. B. Systeme aus dem Enterprise-Resource-Planning (ERP), der Personalwirtschaft oder der Rechnungslegung sein. Externe Quellen sind beispielsweise Daten aus dem Web, von Wirtschaftsforschungsinstitutionen, Lieferanten oder Kunden (Müller & Lenz, 2013, S. 18). Dabei kann es sich um strukturierte oder unstrukturierte Daten handeln (Kemper, Baars & Mehanna, 2010, S. 11). Strukturierte Daten können in Zeilen oder Spalten dargestellt werden. Bei den unstrukturierten Daten (z.B. Videos, Bilder oder E-Mails) ist dies nicht möglich. Der Vorteil von unstrukturierten Daten liegt darin, dass diese nicht nur blosse Fakten liefern. Sie bieten den Entscheidungstragenden auch Indizien, welche aus strukturierten Daten nicht ersichtlich sind (Steinecke & Straub, 2010, S. 91).

Das Data Warehouse dient somit bei Datenauswertungs-Fragen als Single Point of Truth (SPOT) (Ereth & Kemper, 2016, S. 460). Dies bietet den Vorteil, dass sämtliche Mitarbeitenden Auswertungen mit demselben integrierten Datenbestand im Data Warehouse ausführen. Die Auswertungsmöglichkeiten im Data Warehouse sind deutlich umfangreicher und flexibler als z. B. in einem ERP-System. Ausserdem beeinträchtigen komplexe Abfragen dank der Trennung von Data Warehouse und Quellsystemen die Performance der operativen Quellsysteme nicht (Schön, 2018, S. 316–318).

ETL-Prozess und Datenverwaltung

Die Daten aus den Quellsystemen werden mittels ETL-Prozessen ins Data Warehouse importiert. ETL steht dabei für Extraktion, Transformation, Laden. Bei der Extraktion werden die relevanten Daten in den Quellsystemen identifiziert und in einem Arbeitsbereich des Data Warehouse abgelegt. Danach werden die extrahierten Daten im Teilschritt Transformation zusammengeführt, harmonisiert, mit zusätzlichen Informationen angereichert und von syntaktischen Mängeln bereinigt, damit sie in die einheitliche Datenstruktur des Data Warehouse passen. Beim dritten Teilschritt, dem Laden, werden die extrahierten und transformierten Daten in die Zieldatenbank des Data Warehouse transferiert (Schön, 2018, S. 348–350; Müller & Lenz, 2013, S. 26–27). Aus dem Kern-Data-Warehouse werden die Daten dann gezielt in kleinere Data Marts überführt. Die Data Marts erfüllen spezifische Aufgabenbereiche und genau für diese speziellen Einsatzgebiete werden die Daten sinnvoll aufbereitet (Schön, 2018, S. 342).

Datenauswertung und -nutzung

Liegen die Datenbestände im Kern-Data-Warehouse oder den Data Marts bereit, so kann das Unternehmen sie mit Hilfe unterschiedlicher Analyse-, Präsentations- und Planungstools auswerten und zur Informationsgewinnung nutzen. Es existieren zwei grundlegende Typen von Auswertungsanwendungen: Deskriptive/diagnostische Analyseanwendungen und explorative Analyseanwendungen (Schön, 2018, S. 345–346).

Die traditionellen Einsatzgebiete von Business Intelligence sind deskriptive (Was ist passiert?) und diagnostische (Warum ist etwas passiert?) Analyseanwendungen (Ereth & Kemper, 2016, S. 459). Darunter fallen z. B. SQL-basierte freie Datenrecherchen, die Analyse von Daten mittels OLAP-Berichtsgeneratoren (Online Analytical Processing) oder visuell gestaltete Dashboards die als Reporting-Tools für das Management dienen (Schön, 2018, S. 346). Abbildung 2 veranschaulicht ein Beispiel der in der BI wichtigen mehrdimensionalen OLAP-Datenwürfel. Mittels Drill-Down und Roll-Up Funktionalitäten können Mitarbeitende umfangreiche Datenbestände schnell und einfach mit verschiedenen Kriterien analysieren. Wenn Mitarbeitende der Fachabteilungen solche ad-hoc-Abfragen oder Dashboards im Data Warehouse unabhängig von der IT-Abteilung oder dem Controlling erstellen können, so spricht man von Self-Service Business Intelligence.

Die zweite Gruppe von Auswertungsanwendungen bilden die explorativen Analyseanwendungen. Sie beantworten vor allem prädikative (Was wird passieren?; vgl. Predictive Forecasting) und präskriptive (Was ist zu tun?) Fragestellungen. Dazu gehört z. B. Data Mining bei welchem mittels ausgeklügelten mathematischen Modellen und Algorithmen in riesigen Datenmengen nach Mustern und Auffälligkeiten gesucht wird. Diese Anwendungen fallen eher in den Bereich von Business Analytics, welcher über den deskriptiven/diagnostischen Bereich von Business Intelligence hinausgeht (Ereth & Kemper, 2016, S. 459–460).

Quellen

- Ereth, J. & Kemper, H.-G. (2016). Business Analytics und Business Intelligence. Controlling, 28 (8–9), 458–464.

- Kemper, H.-G., Baars, H., & Mehanna, W. (2010). Business Intelligence. Grundlagen und praktische Anwendungen. (3. Aufl.). Wiesbaden: Vieweg+Teubner.

- Müller, R. M. & Lenz, H.-J. (2013). Business Intelligence. Berlin: Springer Vieweg.

- Schön, D. (2018). Planung und Reporting im BI-gestützten Controlling (3. Aufl.). Wiesbaden: Springer Gabler.

- Schön, D. & Liebe, M. (2014). Integrierte Planung und Reporting mit Business-Intelligence-gestütztem Controlling. Controlling, 26 (4–5), 244–251.

- Steinecke, U. & Straub, W. (2010). Unstrukturierte Daten im Business Intelligence. Vorgehen, Ergebnisse und Erfahrungen in der praktischen Umsetzung. HDM Praxis der Wirtschaftsinformatik. 47 (1), 91–101.

Autoren

Alain Birrer, Marlena Bösch, Jasmin Erzer, Céline Geissbühler