Datenmanagement

Datenmanagement ist derjenige Prozess, der am meisten von der digitalen Transformation beeinflusst wird (Gleich & Tschandl, 2018, S. 73). Dies führt dazu, dass die bestehenden Produktionsfaktoren um den zusätzlichen Faktor Information/Wissen ergänzt werden (Biesel & Hame, 2018, S. 24). Am Ursprung des zusätzlichen Produktionsfaktors stehen Big Data, welche aufgrund von sozialen Netzwerken und Internet der Dinge exponentiell anwachsen (Göbel, 2018, S. 20).

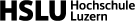

Das Datenmanagement umfasst eine grosse Bandbreite von Themen und damit verbundenen Aktivitäten. Im weiteren Sinne sind darin Begriffe wie Data Warehouse, Business Intelligence, Business Analytics oder Data Mining enthalten. Wird die Definition enger eingegrenzt, ist das Datenmanagement die Schnittstelle zwischen der Datenerhebung und der Datenverwendung. Wichtig in diesem Zusammenhang sind die Datenqualität, die Single Version of Truth sowie die Begriffe Datenschutz und Datensicherheit (Langmann, 2019, S. 8).

Definition von Datenmanagement

Vereinfacht steht das Datenmanagement für die Handhabung von unternehmensrelevanten Stamm- und Bewegungsdaten (Langmann, 2019, S. 32). Dabei gibt es viele Daten wie beispielsweise Produkt- oder Kundendaten, die aus internen Systemen gewonnen werden. Auf der anderen Seite liefern die Big Data eine enorme Vielfalt an strukturierten und nicht strukturierten externen Daten (Ereth & Kemper, 2016, S. 458). Weil die Daten sich schnell verändern können, ist es wichtig, diese fortlaufend zu beschaffen, aufzubereiten und zu bereinigen. Nur so kann eine gute Qualität gewährleistet werden. Dieser Prozess wird als Datenmanagement bezeichnet (Langmann, 2019, S. 8).

Ziele

Übergeordnetes Ziel des Datenmanagement für das Controlling ist es, dem Management die für die Unternehmenssteuerung relevanten Informationen in hoher Qualität und inhaltlich korrekt bereitzustellten (Gleich & Tschandl, 2018, S. 80). Daher muss der digitale Controller verstehen, wie die Daten im Unternehmen erfasst, aggregiert und abgelegt werden, damit die Datenaufbereitung möglichst produktiv verläuft (Egle & Keimer, 2018, S. 53). Ein optimales Datenmanagement kommt jedoch nicht nur den Controlling-Prozessen zugute, sondern wirkt sich letztlich durch eine verbesserte Entscheidungsgrundlage auf die gesamte Unternehmenssteuerung aus (Gleich & Tschandl, 2018, S. 80-81). Mit einem sinnvoll gestaltetem Datenmanagement lassen sich geforderte Ziele auf Unternehmensebene erreichen. Planungsvorgänge werden optimiert und unterstützen eine schnelle und sichere Entscheidungsfindung (Gondring & Wagner, 2018, S. 404-405).

Herausforderungen

Fakt ist, dass die zur Verfügung stehenden Daten exponentiell anwachsen, weshalb das Datenmanagement einerseits von grosser Bedeutung ist, andererseits aber auch vor grosse Herausforderungen gestellt wird (Gleich & Tschandl, 2018, S. 81). Die folgenden fünf Faktoren sind für Unternehmen die relevantesten Herausforderungen im Bereich Datenmanagement (Otto & Österle, 2016, S. 17-19):

- Datenqualität

- Transparenz über Datennutzung

- Redundante Datenpflege

- Manuelle Datenpflege

- Limitationen zentraler Datenarchitekturen

Umsetzung und Nutzen

Bei der immensen Datenmenge ist es wichtig, Transparenz im Datenbestand und in den Datenquellen zu wahren. Damit ein effektives Arbeiten mit Daten möglich ist, müssen klare Prozesse und Verantwortlichkeiten festgelegt werden. Das Data Warehouse dient als zentrale Stelle, wo die gesammelten und bereinigten Daten hinterlegt sind (Biesel & Hame, 2018, S. 27). Von hier aus werden die Daten auf verschiedene Art und Weise eingesetzt und miteinander in Verbindung gebracht. Häufig steht die Datennutzung im Zusammenhang mit Business Intelligence und Business Analytics. Business Intelligence beschreibt dabei Aktivitäten zur Integration, Transformation und qualitativen Verbesserung sowie statischen Analysen der Daten (Müller & Lenz, 2013, S. 3). Business Analytics ist ergänzend zu Business Intelligence, um Zukunftsvoraussagen und Handlungsempfehlungen zu generieren (Derwisch et al., 2016, S. 480). Die Abbildung 1 zeigt den Zusammenhang von den Rohdaten, über das Data Warehouse und Datenmanagement bis zu Business Intelligence und Business Analytics.

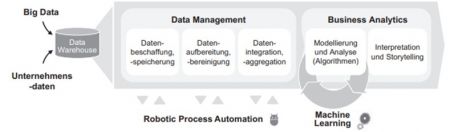

Für das Controlling bedeutet der Prozess Datenmanagement, dem Management die benötigten Informationen für Entscheidungs- und Planungsprozesse situationsgerecht zur Verfügung zu stellen (Inmon, 1996, S. 33, zit. in Müller & Lenz, 2013, S. 14). Weil die gelieferten Daten für die Unternehmenssteuerung von zentraler Bedeutung sind, müssen sie inhaltlich korrekt und in hoher Qualität verarbeitet sein. In einer ersten Phase muss die Komplexität der Daten reduziert werden, um das Verständnis zu erleichtern. Das wiederum muss regelmässig kontrolliert werden, damit Handlungsbedarf frühzeitig erkannt wird (Gleich & Tschandl, 2018, S. 80-81). Die Abbildung 2 zeigt den Prozess Datenmanagement im Controlling. Es handelt sich um eine schematische Darstellung von links nach rechts. Beim Prozessanfang wird die Ausgangslage definiert und mittels Input bestimmt, welche Mittel vorhanden sind. Die verschiedenen Teilprozesse werden anschliessend aufeinander abge-stimmt und sollen die im Prozessende definierten Punkte erfüllen. Eine Messung kann anhand der realisierten Outputs erfolgen. Der Prozess wird laufend wiederholt und überarbeitet (Möller & Illich-Edlinger, 2018, S. 57).

Datenqualität

Damit die genannten Instrumente wie Business Intelligence und Analytics in einem Unternehmen gewinnbringend eingesetzt werden können, müssen die verwendeten Daten eine gute Qualität aufweisen (Klier & Heinrich, 2016, S. 488). Mit Datenqualität ist die Eignung von Daten für eine bestimmte Nutzung bei vorgegebenen Verwendungszielen gemeint. Die Qualität hängt also davon ab, welche Qualitätseigenschaften den Daten zugeordnet werden. Wichtig ist dabei der beabsichtigte Anwendungskontext (Müller & Lenz, 2013, S. 38). Die Datenqualität kann nur beurteilt werden, wenn sie messbar ist (Otto & Legner, 2016, S. 552). Es gibt vier Hauptkriterien, nach welchen die Daten qualifiziert werden (Müller & Lenz, 2013, S. 38–40):

| Qualitätsmerkmal | Beschreibung |

|---|---|

| Glaubwürdigkeit | Bei der Glaubwürdigkeit geht es darum zu beurteilen, ob die Daten korrekt und konsistent sind. Zudem ist es wichtig zu überprüfen, ob die Daten zuverlässig sind. |

| Nützlichkeit | Damit Daten für ein Unternehmen nützlich sind, müssen sie vollständig, genau und relevant sein. Hinzu kommt, dass die Daten zeitnah erhoben und eingesetzt werden. Mehrspurige Erhebungen derselben Daten sind zu vermeiden. |

| Interpretierbarkeit | In Bezug auf die Weiterverarbeitung der Daten ist es wichtig zu überprüfen, ob die Daten einheitlich sind und eindeutig als bestimmte Daten identifiziert werden können. |

| Schlüsselintegrität | Bei der Schlüsselintegrität geht es darum, dass die Daten untereinander verbunden werden können. Dafür darf es keine doppelten Daten geben. So ist es zentral, dass eine Bank beispielsweise nur einmal die gleiche Kontonummer vergibt. |

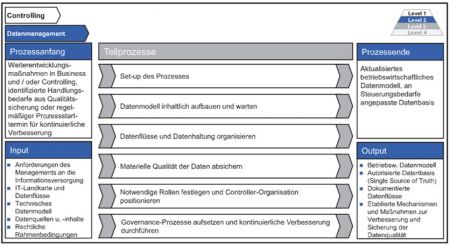

Die Datenqualität kann ebenfalls aus einem anderen Blickwinkel betrachtet werden. Es werden dabei die Perspektiven der Design- und Konformitätsqualität unterschieden. Die Abbildung 3 stellt die beiden Qualitätskomponenten in einer Übersicht dar (Klier & Heinrich, 2016, S. 489).

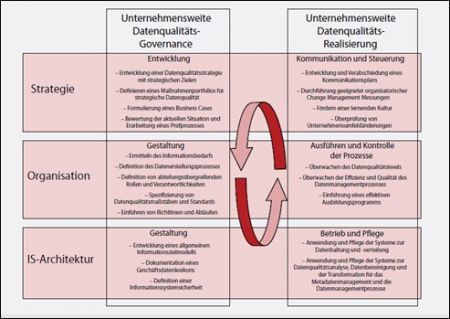

Die Designqualität beschreibt, inwiefern die nachgefragten Daten durch die spezifizierten Daten abgedeckt werden. Ein Beispiel der Designqualität ist, inwiefern alle Serviceauftragsattribute, welche die geplante Datenanalyse zur Unterstützung des Serviceauftragsmanagements benötigt werden (z.B. Servicestatus, Servicetyp, Auftraggeber), im Datenschema des Informationssystems tatsächlich erfasst sind. Die Designqualität wird gemessen, indem auf Informationsbedarfsanalysen und Befragungen der Datenanwender zurückgegriffen wird (Klier & Heinrich, 2016, S. 489). Die Konformitätsqualität hingegen beschreibt, inwiefern die vorhandenen Daten und die zugehörigen Realweltausprägungen aufeinander abgestimmt sind. Ein Beispiel dafür ist, ob die gespeicherten Serviceauftragsdaten mit den tatsächlichen Auftragsdaten übereinstimmen. Die Beurteilung der Konformitätsqualität erfolgt durch verschiedene Datenqualitätsmerkmale. Datenqualitätsmerkmale sind beispielsweise Korrektheit, Vollständigkeit oder Aktualität. Im Fokus liegt das Datenqualitätsmerkmal Aktualität. Mit Aktualität ist gemeint, dass die gespeicherten Datenwerte nach wie vor der Realwelt entsprechen und nicht veraltet sind. Aus betriebswirtschaftlicher Perspektive ist das hoch relevant (Klier & Heinrich, 2016, S. 489-490). Für die Überprüfung der Qualitätsmessung empfiehlt sich ein Datenqualitätsmanagement in einer unternehmensweiten Perspektive. Ein ganzheitliches Modell mit einer langfristigen Orientierung wird dem gerecht. In der Abbildung 4 wird das CDQ-Modell als ein mögliches Beispiel dargestellt. Die Zeilen der Matrix bilden die drei Ebenen des Business Engineering (Strategie, Organisation und Informationssystem-Architektur). Ausserdem wird die Governance und Realisierung getrennt. Die eng miteinander verbundenen Verfahren werden in einem Steuerungskreislauf angeordnet (Baumöl & Meschke, 2009, S. 64–65).

Single Version of Truth

Datenqualitätsprobleme entstehen häufig dann, wenn nicht klar definiert ist, wo die Daten gespeichert sind oder es gar mehrere Dokumenten- oder Datenversionen gibt (Otto & Legner, 2016, S. 553). Wie schon erwähnt, ist das Data Warehouse die zentrale Stelle, um Daten zu sammeln. Wichtig ist zu verstehen, dass es sich um eine anwendungsübergreifende und integrierte Datenhaltungskomponente handelt (Ereth & Kemper, 2016, S. 459). Die Daten aus den verschiedenen Quellensystemen werden im Data Warehouse vereint und stehen zur Verfügung. Es handelt sich um das Herzstück eines Unternehmens. Unabhängig von Zeit, Arbeitsort oder Funktion kann zentral auf die benötigten Unternehmensdaten zugegriffen werden. Es gibt also eine „Single Version of Truth“ (nachfolgend SVOT) (Kemper et al., 2010, S. 226-227). Das Ziel einer SVOT besteht darin, die einzig richtige Version von ausgewerteten Daten zu erhalten, welche als Entscheidungsgrundlage dienen (Bundi & Keimer, 2009, S. 64-65). Es soll verhindert werden, dass beispielsweise Produktdaten aus verschiedenen Systemen eines Unternehmens nicht übereinstimmen. Wenn alle im gleichen Data Warehouse zentral auf identische Daten zugreifen, besteht diese Gefahr von Unstimmigkeiten und fälschlicher Entscheidungsgrundlagen nicht. Einerseits liefert das Data Warehouse vordefinierte Standardberichte und andererseits ist es möglich Ad-hoc-Berichte zu generieren. Dabei können praktisch auf Knopfdruck personalisierte Berichte erstellt werden, die auf das aktuelle Informationsbedürfnis zugeschnitten sind (Müller & Lenz, 2013, S. 12). Es wird in diesem Zusammenhang von bedarfsorientierter Informationsverfügbarkeit gesprochen (vgl. Self-Service Business Intelligence). Das ist eine wichtige Entwicklung, denn als ein zentraler Erfolgsfaktor der Zukunft gilt es, beliebige Daten kontextbasiert und in Echtzeit zur Verfügung zu haben (Leyk et al., 2017, S. 58).

Datenschutz und Datensicherheit

Die beiden Begriffe Datenschutz und Datensicherheit bewegen sich zwar in einem ähnlichen Umfeld, müssen jedoch voneinander abgegrenzt werden (Bühler et al., 2019, S. 80). Beim Datenschutz geht es darum, die persönlichen Daten der Menschen zu schützen. Die unzähligen Daten (vgl. Big Data), welche täglich im Internet kursieren, beinhalten persönliche Daten der Menschen. Unternehmen regeln den Gebrauch von persönlichen Daten häufig in den allgemeinen Geschäfts- oder Nutzungsbedingungen. Es gibt aber für jede Person das Recht auf Auskunft zu den eigenen persönlichen Kundendaten. Ebenfalls kann deren Löschung beantragt werden (Bühler et al., 2019, S. 81). Weil bei einem Verstoss gegen Richtlinien des Datenschutzes empfindliche Strafen ausgesprochen werden, ist es für ein Unternehmen sehr wichtig, die geltenden Bestimmungen zu kennen. Ein dafür vorgesehenes Risiko-Management sollte die im Unternehmen geltenden Prozesse und Abläufe im Zusammenhang mit Daten laufend überprüfen und auf Veränderungen reagieren (Possekel & Schiemann, 2017, S. 58-59). Datensicherheit geht im Vergleich zum Datenschutz einen Schritt weiter und umfasst nicht nur persönliche Daten, sondern Daten aller Art. Datensicherheit sorgt dabei durch entsprechende Massnahmen dafür, dass Daten beständig sind, nicht ungewollt verändert oder gar entwendet werden (Bühler et al., 2019, S. 80). Die Bedeutung von Datensicherheit im Controlling nimmt laufend zu. Herausforderungen sind neben der Einhaltung von geltenden Richtlinien (Datenschutzbestimmungen) auch die Nachvollziehbarkeit der Datenherkunft (Bundi & Keimer, 2019, S. 65). Zur Gefährdung der Datensicherheit können verschiedene Faktoren beitragen. Nachfolgend werden diese in sieben Hauptpunkten zusammengefasst (Adam, 1995, S. 14):

| Fehlerquelle | Beschreibung |

|---|---|

| Programmfehler | Programmfehler entstehen z.B. durch eine falsch programmierte Programmroutine, die bei den Tests, die vor dem Einsatz des betreffenden Programmes durchgeführt wurden, nicht aufgefallen ist und unter bestimmten Einsatzbedingungen, wie etwa bei gross gewordenen Zahlenwerten, Daten verfälscht oder zerstört. |

| Hardwaredefekte | Durch den Ausfall wichtiger Hardwarekomponenten, hier sind besonders die Massenspeicher zu nennen, können im System gespeicherte Daten verloren gehen. |

| Schadenprogramme | Schadenprogramme sind spezielle Programme, wie etwa Computerviren, deren einziger Zweck es ist Programme und Daten zu zerstören. |

| Demotivierte Anwender | Demotivierte Anwender sind Anwender, die bewusst Fehler machen oder einen aufgetretenen Systemfehler ignorieren. |

| Katastrophen | Nicht oder nur schwer vorhersehbare Katastrophen, die für die Zerstörung der Hardware und der darauf gespeicherten Daten verantwortlich sein können, sind Feuer (Gebäudebrand), Wasser (Hochwasser, Wasserrohrbruch) und Gebäudeschäden (Gasexplosion, Erdbeben). |

| Hacker | Hacker nennt man Personen, die von aussen über einen Datenfernübertragungsanschluss in das System eindringen und dort Daten ausspionieren oder manipulieren. |

| Diebstahl | Diebstahl von kompletten Rechnersystemen (PC, Notebook) oder die Entwendung einzelner Datenträger, auf denen wichtige Informationen gespeichert sind, muss verhindert werden. |

Folgende organisatorische Massnahmen können zur Verbesserung der Datensicherheit angewandt werden (Bundi & Keimer, 2019, S. 66):

| Instrument | Beschreibung |

|---|---|

| Berechtigungskonzept | Es gilt ein Berechtigungskonzept aufzustellen, welche gemäss der Data Governance den Datenzugang definiert. Es sind die berechtigten Personen und sowie die möglichen Applikationen/Devices zu bestimmen. |

| Datenprotokoll | Veränderungen von Datenbeständen sollen unbedingt protokolliert werden. So kann nachvollzogen werden, ob berechtigte oder unberechtigte Anpassungen vorgenommen wurden. |

| Schutz vor Fremdzugriff | Mittels gängigen Schutzmassnahmen wie Passwortschutz oder Bildschirmsperre soll der Datenzugriff durch Unbefugte verhindert werden. |

Lern- und Praxismaterialien

| Fallstudie |

|---|

Quellen

Literaturverzeichnis

- Adam, U. (1995). Einführung in die Datensicherheit. Vogel.

- Baumöl, U. & Meschke, M. (2009). Das Management von Datenqualität: Transfer. Controlling & Management, 53(1), 62–65.

- Biesel, H. & Hame, H. (2018). Vertrieb und Marketing in der digitalen Welt : So schaffen Unternehmen die Business Transformation in der Praxis (1 Ausg.). Springer Gabler.

- Bühler, P., Schlaich, P. & Sinner, D. (2019). Datenmanagement Daten – Datenbanken – Datensicherheit. Springer Vieweg.

- Bundi, M. & Keimer, I. (2019). Das digitale Potenzial der Daten besser nutzen. Controlling & Management Review, 63(8), 62–67.

- Derwisch, S., Iffert, L., Fuchs, C., & Bange, C. (2016). Business Analytics-Software für das Controlling – eine Marktübersicht. Controlling – Zeitschrift für erfolgsorientierte Unternehmenssteuerung(28), S. 480-487.

- Egle, U. & Keimer, I. (2018). Kompetenzprofil "Digitaler Controller". Controller Magazin, 43(5), 49-53.

- Ereth, J. & Kemper, H.-G. (2016). Business Analytics und BusinessIntelligence: Säulen eines integrierten Ansatzes der IT-basiertenEntscheidungsunterstützung. Controlling(8-9), 458- 464.

- Gleich, R. & Tschandl, M. (2018). Digitalisierung & Controlling. Technologien, Instrumente, Praxisbeispiele (1 Ausg.). Haufe.

- Göbel, U. (2018). Von Big zu Smart Data. Next Industry, (02), 20-24.

- Gondring, H. & Wagner, T. (2018). Facility Management. Handbuch für Studium und Praxis (3. Aufl.). Vahlen.

- Kemper, H.-G., Baars, H. & Mehanna, W. (2010). Business Intelligence – Grundlagen und praktische Anwendungen: Eine Einführung in die IT-basierte Managementunterstützung (3 Ausg.). Vieweg+Teubner.

- Klier, M. & Heinrich, B. (2016). Datenqualität als Erfolgsfaktor im Business Analytics. Controlling- Zeitschrift für erfolgsorientierte Unternehmenssteuerung, 28(8-9), 488-494.

- Langmann, C. (2019). Digitalisierung im Controlling (1 Ausg.). Springer Gabler.

- Leyk, J., Kirchmann, M. & Tobias, S. (2017). Planung, Forecast und Reporting der digitalen Welt. In Digitalisierung der Unternehmenssteuerung: Prozessautomatisierung, Business Analytics, Big Data, SAP S/4HANA, Anwendungsbeispiele (S. 1–184). Schäffer-Poeschel.

- Möller, K. & Illich-Edlinger, S. (2018). IGC Controlling-Prozessmodell 2.0. International Group of Controlling (Hrsg.) Controlling, 30(2), 55-58.

- Müller, R. M. & Lenz, H.-J. (2013). Business Intelligence (1st ed. 2013.). Springer Vieweg.

- Otto, B. & Legner, C. (2016). Datenqualitätsmanagement für den Industriebetrieb. Controlling – Zeitschrift für erfolgsorientierte Unternehmenssteuerung (28), 550-557.

- Otto, B. & Österle, H. (2016). Corporate Data Quality. Voraussetzung erfolgreicher Geschäftsmodelle. (2016). Springer.

- Possekel, M. & Schiemann, S. (2017). Risiko Datenschutz. Controlling & Management Review, 61(8), 58–61.

Weiterführende Literatur

- Eckert, C. & Fallenbeck, N. (2015). Industrie 4.0 meets IT-Sicherheit: eine Herausforderung!. Informatik Spektrum (38), 217–223.

- Fürber, C. & Sobota, J. (2011). Eine Datenqualitätsstrategie für große Organisationen am Beispiel der Bundeswehr. HMD Praxis der Wirtschaftsinformatik, 48(3), 36–45.

- Hinrichs, H. (2002). Datenqualitätsmanagement in Data-Warehouse-Systemen [Dissertation]. Universität Oldenburg Schäffer, U. (2018). Wenn die Leute sich ihre Fakten selbst besorgen – super! Controlling & Management Review(62), 32-37.

- Weber, K., Otto, B. & Österle, H. (2009). Data Governance: Organisationskonzept für das konzernweite Datenqualitätsmanagement.

- Zwirner, M. (2018). Datenbereinigung zielgerichtet eingesetzt zur permanenten Datenqualitätssteigerung. In K. Hildebrand, M. Gebauer, H. Hinrichs, & M. Mielke (Hrsg.), Daten- und Informationsqualität: Auf dem Weg zur Information Excellence (S. 101–120). Springer Fachmedien.

Autoren

Merve Köse, Michael Kronenberg, Patrick Lötscher, Valentin Leipold